GreenNode หนึ่งในธุรกิจของ VNG ผู้เชี่ยวชาญบริการ AI Cloud และเป็นพันธมิตร NVIDIA Cloud Partner (NCP) เปิดตัวคลัสเตอร์ข้อมูล AI ขนาดใหญ่ หรือ large-scale AI Data cluster ในกรุงเทพฯ ประเทศไทย อย่างเป็นทางการ โดย GreenNode ตั้งเป้าเป็นผู้นำบริการ AI Cloud ในภูมิภาคเอเชีย ด้วยการเพิ่มทรัพยากร AI ที่มีประสิทธิภาพการประมวลผลขั้นสูงเพื่อเพิ่มศักยภาพแก่ธุรกิจ AI ในภูมิภาค

ดาต้าเซ็นเตอร์แห่งนี้เป็นหนึ่งในดาต้าเซ็นเตอร์ระดับไฮเปอร์สเกลที่รองรับ AI เป็นแห่งแรกของเอเชียตะวันออกเฉียงใต้ ซึ่งดำเนินการโดยทีม Cloud Operation Excellence ของ GreenNode

มร.เดนนิส แอง ผู้อำนวยการอาวุโส ฝ่ายธุรกิจองค์กร ประจำภูมิภาคอาเซียนและออสเตรเลีย-นิวซีแลนด์ ของ NVIDIA ย้ำถึงองค์ประกอบสำคัญสองประการที่ทำให้องค์กรก้าวนำหน้าท่ามกลางกระแส GenAI ณ ปัจจุบัน ได้แก่ ดาต้าเซ็นเตอร์ AI และ โรงงาน AI ซึ่งเป็นสิ่งที่ NVIDIA ทำงานร่วมกันอย่างใกล้ชิดกับทั้งทีม VNG GreenNode และ ST Telemedia Global Data Centres (STT GDC) "จากความร่วมมือนี้ เราได้ร่วมกันสร้างและส่งมอบองค์ประกอบสำคัญทั้งสองด้านนี้ให้แก่ลูกค้า ผมขอแสดงความยินดีกับ VNG GreenNode กับความสำเร็จนี้ และ NVIDIA พร้อมให้ความร่วมมือเพิ่มเติมในอนาคต"

คลัสเตอร์ AI Cloud ของ GreenNode ในดาต้าเซ็นเตอร์ STT Bangkok 1 ที่ตั้งอยู่ใจกลางกรุงเทพฯ เป็นไปตามมาตรฐานระดับโลก โดยได้รับการรับรองมากมาย อาทิ LEED ระดับ Gold, TIA 942 Rating-3 DCDV และมาตรฐาน Uptime Tier III ซึ่ง GreenNode มีเป้าหมายสำคัญในการส่งมอบโซลูชันครบวงจรให้กับทุกธุรกิจที่เดินหน้าสู่เส้นทางของ AI โดยปรับใช้โครงสร้างพื้นฐาน AI ที่มีขนาดกำลังไฟสูงถึง 20 เมกะวัตต์ และติดตั้งเครือข่าย InfiniBand ล่าสุด ซึ่งให้แบนด์วิดท์สูงถึง 3.2 เทระไบต์ต่อวินาที สำหรับรันการทำงานเซิร์ฟเวอร์ของ GreenNode รวมถึงมีแพลตฟอร์มการจัดเก็บข้อมูลแบบไฮเปอร์สเกลสำหรับผู้เช่าหลายรายที่แตกต่างกัน พร้อมมอบบริการ AI Cloud ที่แข็งแกร่งและโครงสร้างพื้นฐาน GPU แก่ทุกลูกค้า

ระหว่างการกล่าวบรรยายในช่วงพิธีการของ มร.ลิโอเนล เยียว ประธานเจ้าหน้าที่บริหาร เอสที เทเลมีเดีย โกลบอล ดาต้า เซ็นเตอร์ ประจำภูมิภาคเอเชียตะวันออกเฉียงใต้ กล่าวว่า "อีก 4 ปีข้างหน้านี้ การลงทุน AI จะเพิ่มขึ้นอย่างมาก โดยมาจากภูมิภาคเอเชียแปซิฟิกประมาณ 30% ซึ่งในภูมิภาคนี้มีความเคลื่อนไหวไดนามิกเพิ่มขึ้นเรื่อย ๆ ส่งผลให้ความร่วมมือในวันนี้มีความสำคัญยิ่งขึ้น ผมขอแสดงความยินดีกับ VNG GreenNode กับความสำเร็จที่สามารถนำ AI Cloud มาใช้เชิงพาณิชย์ได้ภายในระยะเวลาเพียง 6 เดือน และเชื่อว่าหากเราร่วมมือกัน ภายในไม่กี่ปีข้างหน้านี้จะสามารถผลักดันให้ภูมิภาคเอเชียก้าวขึ้นเป็นผู้นำในกระแสเทคโนโลยีระดับโลก

ผลิตภัณฑ์พอร์ตโฟลิโอของ GreenNode ประกอบด้วย 3 กลุ่มหลัก ได้แก่ กราฟิกการ์ด แบบ Bare Metal ที่มีชิปประมวลผล H100 Tensor Core นับพันตัว, แพลตฟอร์มแมชชีนเลิร์นนิ่ง (Machine Learning หรือ ML) และสิทธิ์การเข้าถึงทรัพยากร บริการ หรือ เทคโนโลยีใน NVIDIA AI Factory โดย GreenNode เป็นบริษัทที่มุ่งเน้นผลิตภัณฑ์ที่ไม่เพียงแต่ช่วยเพิ่มประสิทธิภาพในโครงสร้างพื้นฐานเท่านั้น แต่ยังรวมถึงการฝึกอบรมโมเดลและแพลตฟอร์ม AI ขั้นสูง โดยอาศัยความเชี่ยวชาญเพื่อสนับสนุนบริษัทสตาร์ทอัพผ่านรูปแบบของตนเอง วิธีการนี้ถือเป็นจุดขายที่ย้ำถึงพันธกิจของ GreenNode ที่มุ่งมั่นสร้างความเป็นเลิศในด้านการดำเนินงาน

GreenNode ยังเป็นผู้บุกเบิกในภูมิภาคเอเชียตะวันออกเฉียงใต้ที่สร้างและนำเสนอแพลตฟอร์มการจัดการพารามิเตอร์ระยะไกล ช่วยให้ลูกค้ากลุ่มธุรกิจในทุกขนาดทั่วโลกสามารถเข้าถึงและปรับขนาดพารามิเตอร์การฝึกอบรมได้อย่างยืดหยุ่น ประหยัดทั้งเวลาและกำลังคน

“การเปิดตัวคลัสเตอร์ข้อมูล AI ครั้งนี้เป็นหมุดหมายสำคัญที่ให้สัญญาณเชิงบวกทั้งในด้านความก้าวหน้าทางเทคโนโลยีและผลการดำเนินงานทางธุรกิจ เนื่องจากแนวคิดดังกล่าวได้ถูกนำไปใช้จริงอย่างรวดเร็วในระยะเวลาอันสั้น นี่เป็นเพียงก้าวแรกและเรามุ่งมั่นที่จะลงทุนในระยะยาวเพื่อเป็นผู้ให้บริการ AI Cloud ชั้นนำในเอเชียตะวันออกเฉียงใต้” มร. เล ฮอง มิน ผู้ก่อตั้งและซีอีโอของ VNG กล่าว

เมื่อเร็ว ๆ นี้ GreenNode ได้บรรลุข้อตกลงมูลค่าหลายล้านดอลลาร์เพื่อมอบโครงสร้างพื้นฐาน AI และโซลูชัน AI ขั้นสูงให้กับลูกค้าทั่วโลก

"GreenNode ตั้งเป้าที่จะเป็นผู้ให้บริการโซลูชันแบบครบวงจรสำหรับลูกค้าทั่วโลกด้วยพลังจากชิป GPU อันนับพันในดาต้าเซ็นเตอร์มาตรฐานสากลของ Nvidia และ STT GDC อย่างไรก็ตามยังมีอีกหลายสิ่งที่เราต้องทำ รวมถึงการลงทุนอย่างต่อเนื่องในการวิจัยและพัฒนาเพื่อเป็นผู้บุกเบิกด้าน AI ในภูมิภาคนี้" มร. เหงียน ลี ทัน ซีอีโอของ GreenNode และ VNG Digital Business กล่าว

ในการประชุมผู้ถือหุ้นประจำปี VNG 2024 ผู้ก่อตั้งและซีอีโอ VNG มร. เล ฮอง มิน ได้เน้นย้ำถึงปัจจัยขับเคลื่อนการเติบโตเชิงกลยุทธ์ของบริษัทในปีต่อ ๆ ไป 3 ประการ ได้แก่ AI, “Go Global” และแพลตฟอร์ม VNG มีความโดดเด่นในฐานะหนึ่งในบริษัทเทคโนโลยีไม่กี่แห่งในเอเชียตะวันออกเฉียงใต้ที่เปิดรับการใช้งาน AI อย่างรวดเร็วและเต็มรูปแบบ ด้วยการลงทุนจำนวนมากในโครงสร้างพื้นฐาน แพลตฟอร์ม และแอปพลิเคชัน VNG ตั้งเป้าที่จะเป็นผู้ให้บริการ AI ชั้นนำในเวียดนามและภูมิภาค

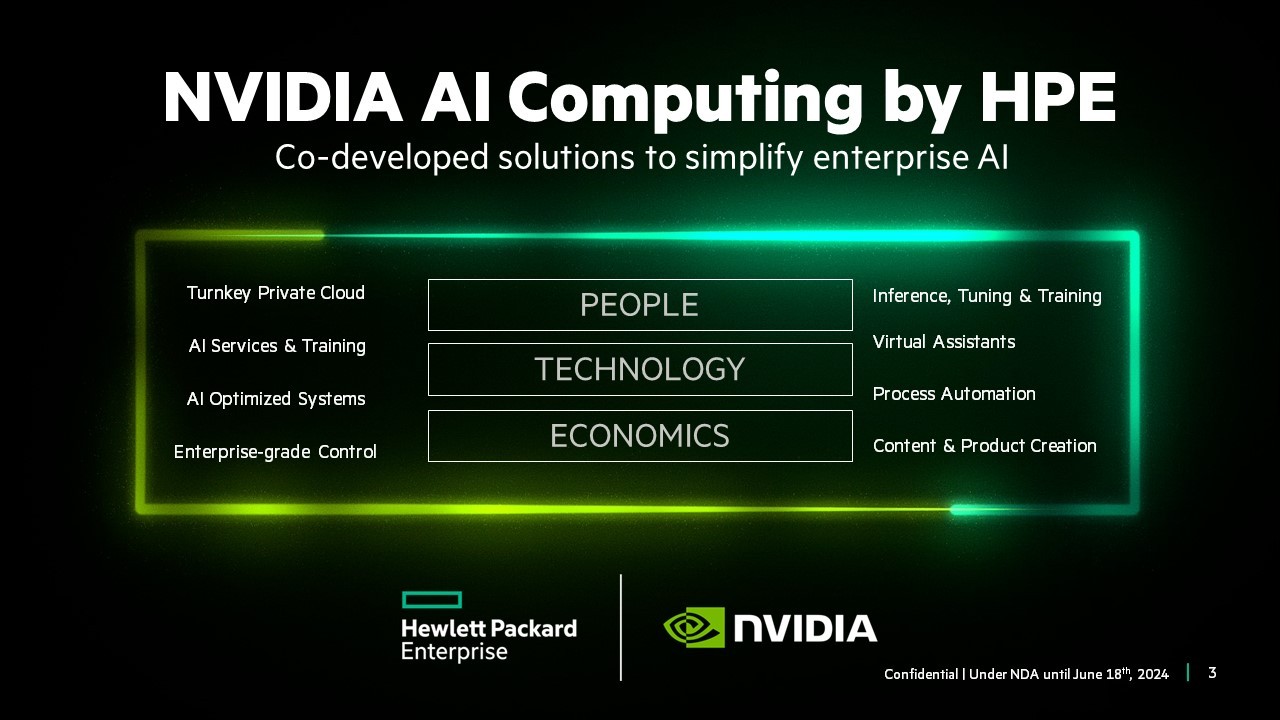

HPE Discover 2024 – บริษัทฮิวเลตต์ แพคการ์ด เอนเตอร์ไพรส์ (Hewlett Packard Enterprise (NYSE: HPE)) และเอ็นวิเดีย (NVIDIA) ได้ประกาศเปิดตัว NVIDIA AI Computing by HPE ซึ่งเป็นผลิตภัณฑ์โซลูชัน AI ที่ได้รับการพัฒนาและออกสู่ตลาดร่วมกัน ซึ่งช่วยให้องค์กรต่าง ๆ สามารถเร่งการนำ Generative AI ไปใช้งานได้รวดเร็วยิ่งขึ้น

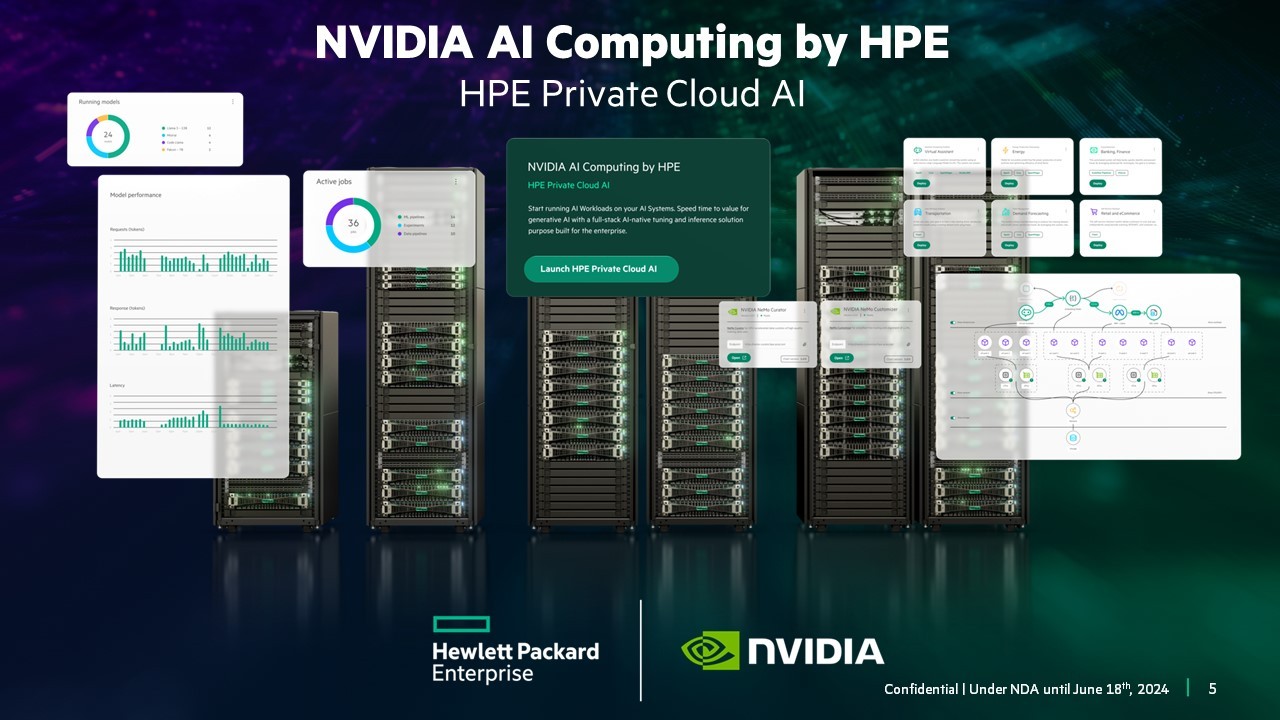

บริการหลักในชุดผลิตภัณฑ์นี้ ได้แก่ HPE Private Cloud AI ซึ่งเป็นโซลูชันแรกที่รวมเอาการผสานที่ล้ำลึกที่สุดจนถึงปัจจุบันของการประมวลผล AI ของ NVIDIA, การสร้างเครือข่าย และซอฟต์แวร์เข้ากับพื้นที่เก็บข้อมูล AI ของ HPE การประมวลผลและระบบคลาวด์ HPE GreenLake เพื่อช่วยให้องค์กรทุกขนาดสามารถพัฒนาและปรับใช้แอปพลิเคชัน Generative AI ได้อย่างยั่งยืน ประหยัดพลังงาน รวดเร็ว และยืดหยุ่นมากยิ่งขึ้น โดย HPE Private Cloud AI ขับเคลื่อนด้วย OpsRamp AI copilot ใหม่ที่ช่วยให้การปฏิบัติการด้าน IT ปรับปรุงเวิร์กโหลดและประสิทธิภาพด้าน IT นอกจากนี้ ยังมาพร้อมประสบการณ์คลาวด์แบบบริการตนเอง รวมถึงการจัดการตลอดอายุการใช้งาน และยังสามารถกำหนดค่าขนาดที่เหมาะสมให้เลือกถึงสี่แบบเพื่อรองรับเวิร์กโหลด AI และเคสการใช้งานที่หลากหลาย

ข้อเสนอและบริการ NVIDIA AI Computing by HPE ทั้งหมดจะถูกนำเสนอผ่านกลยุทธ์การเข้าสู่ตลาด (Go-to-market strategy) ร่วมกัน ซึ่งครอบคลุมถึงการจำหน่าย ทีมงาน พันธมิตรในแต่ละช่องทาง การเทรน และเครือข่ายผู้วางระบบทั่วโลก ได้แก่ Deloitte, HCLTech, Infosys, TCS และ Wipro ซึ่งสามารถช่วยให้องค์กรในอุตสาหกรรมต่าง ๆ ดำเนินงานเวิร์กโหลด AI ที่ซับซ้อนได้

ในระหว่างการประกาศในงาน HPE Discover นายอันโตนิโอ เนรี ประธานและซีอีโอ บริษัทฮิวเลตต์ แพคการ์ด เอนเตอร์ไพรส์ และนายเจนเซ่น หวง ผู้ก่อตั้งและซีอีโอของ NVIDIA ได้ประกาศว่า NVIDIA AI Computing by HPE ถือเป็นการขยายความร่วมมือที่มีมายาวนานหลายทศวรรษ และสะท้อนให้เห็นถึงความมุ่งมั่นที่สำคัญในด้านเวลาและทรัพยากรของทั้งสองบริษัท

นายอันโตนิโอ เนรี ประธานและซีอีโอ บริษัทฮิวเลตต์ แพคการ์ด เอนเตอร์ไพรส์ เปิดเผยว่า “Generative AI มีศักยภาพที่ยิ่งใหญ่ในการปฏิวัติองค์กร แต่ความซับซ้อนของเทคโนโลยี AI ที่ประกอบด้วยหลายส่วนนั้นมีความเสี่ยงและอุปสรรคมากเกินไป ซึ่งจะเป็นอุปสรรคต่อการใช้งานในองค์กรขนาดใหญ่ และอาจเป็นภัยต่อทรัพย์สินที่มีค่าที่สุดของบริษัทซึ่งก็คือข้อมูลที่เป็นกรรมสิทธิ์ของพวกเขา ดังนั้นเพื่อปลดปล่อยศักยภาพอันมหาศาลของ Generative AI ในองค์กร ทาง HPE และ NVIDIA ได้ร่วมกันพัฒนาระบบคลาวด์ส่วนตัวแบบครบวงจรสำหรับ AI โดยจะช่วยให้องค์กรต่างๆ สามารถมุ่งเน้นการใช้ทรัพยากรของตนเองเพื่อพัฒนาการใช้งาน AI แบบใหม่ๆ ซึ่งสามารถช่วยเพิ่มผลงานและเปิดประตูสู่แหล่งรายได้ใหม่ๆ ได้ด้วย"

นอกจากนี้ นายเจนเซน หวง ผู้ก่อตั้งและซีอีโอของ NVIDIA กล่าวว่า “Generative AI และการประมวลผลแบบเร่งความเร็วเป็นแรงผลักดันให้เกิดการเปลี่ยนแปลงรากฐาน เนื่องจากทุกอุตสาหกรรมต่างร่วมกันแข่งขันเพื่อปฏิวัติอุตสาหกรรม ซึ่งก่อนหน้านี้ NVIDIA และ HPE ไม่เคยมีการบูรณาการเทคโนโลยีของเราอย่างลึกซึ้งเช่นนี้มาก่อน โดยการรวมชุดการประมวลผล AI ของ NVIDIA ทั้งหมดเข้ากับเทคโนโลยีคลาวด์ส่วนตัวของ HPE ในครั้งนี้ เราตั้งใจที่จะให้ลูกค้าองค์กรและผู้เชี่ยวชาญระดับมืออาชีพด้าน AI มีโครงสร้างพื้นฐานและบริการคอมพิวเตอร์ที่ทันสมัยที่สุดเพื่อขยายขอบเขตการทำงานของ AI”

HPE และ NVIDIA ร่วมกันพัฒนาผลิตภัณฑ์ Private Cloud AI

HPE Private Cloud AI นำเสนอประสบการณ์บนคลาวด์ที่ไม่เหมือนใครเพื่อเร่งความเร็วในการสร้างนวัตกรรม และเพิ่มผลตอบแทนจากการลงทุน และขณะที่จัดการความเสี่ยงระดับองค์กรจาก AI โดยโซลูชันประกอบด้วย

● รองรับการอนุมาน การปรับแต่งโมเดล และเวิร์กโหลด RAG AI ที่ใช้ข้อมูลที่เป็นกรรมสิทธิ์

● องค์กรสามารถควบคุมข้อกำหนดด้านความเป็นส่วนตัว ความปลอดภัย ความโปร่งใส และการกำกับดูแลข้อมูลได้

● เพิ่มผลิตผลในการทำงาน ด้วยประสบการณ์คลาวด์ เช่น ITOps และ ความสามารถของ AIOps

● มาพร้อมเส้นทางที่รวดเร็วในการใช้ทรัพยากรอย่างยืดหยุ่น เพื่อตอบสนองโอกาสและการเติบโตของ AI ในอนาคต

AI และชุดเครื่องมือซอฟต์แวร์ที่ได้รับการคัดสรรใน HPE Private Cloud AI รากฐานของ AI และเครื่องมือซอฟต์แวร์ข้อมูลเริ่มต้นด้วยแพลตฟอร์มซอฟต์แวร์ NVIDIA AI Enterprise ซึ่งรวมถึงไมโครเซอร์วิสอนุมาน NVIDIA NIM™

NVIDIA AI Enterprise เร่งกระบวนการทางวิทยาศาสตร์ข้อมูลและปรับปรุงกระบวนการพัฒนาและการปรับใช้ Copilot ในระดับการผลิต รวมถึงแอปพลิเคชัน GenAI อื่น ๆ เมื่อรวมกับ NVIDIA AI Enterprise แล้ว NVIDIA NIM จะให้บริการไมโครเซอร์วิสที่ใช้งานง่าย ซึ่งมอบการเปลี่ยนผ่านที่ราบรื่นจากต้นแบบไปจนถึงการปรับใช้โมเดล AI ที่ปลอดภัยในกรณีการใช้งานที่หลากหลาย เสริมด้วย NVIDIA AI Enterprise และ NVIDIA NIM ซอฟต์แวร์ให้สมบูรณ์ยิ่งขึ้น HPE AI Essentials ได้มอบชุดเครื่องมือ AI และรากฐานข้อมูลที่พร้อมใช้งานซึ่งคัดสรรมาแล้ว พร้อมด้วย Control Plane แบบครบวงจรที่มีโซลูชันที่ปรับเปลี่ยนได้ ให้บริการการสนับสนุนองค์กรอย่างต่อเนื่อง และบริการ AI ที่เชื่อถือได้ เช่น การเป็นไปตามข้อกำหนดและคุณสมบัติที่เพิ่มขยายได้ของข้อมูลและโมเดล ที่ช่วยให้มั่นใจว่าการเคลื่อนที่ของข้อมูล AI เป็นไปตามข้อกำหนด เข้าใจได้ และทำซ้ำได้ทั้งหมดของวงจรชีวิต AI เพื่อส่งมอบประสิทธิภาพที่ดีที่สุดสำหรับ AI และชุดซอฟต์แวร์ข้อมูล HPE Private Cloud AI เสนอโครงสร้างพื้นฐาน AI แบบครบวงจร ซึ่งได้แก่เครือข่าย NVIDIA Spectrum-X Ethernet, HPE GreenLake for File Storage และเซิร์ฟเวอร์ HPE ProLiant พร้อมการสนับสนุนสำหรับ NVIDIA L40S, NVIDIA H100 NVL Tensor Core GPUs และ แพลตฟอร์ม NVIDIA GH200 NVL2

ประสบการณ์ที่เกิดขึ้นได้ด้วยคลาวด์ HPE GreenLake

HPE Private Cloud AI นำเสนอประสบการณ์คลาวด์แบบบริการตนเองใช้งานด้วยคลาวด์ HPE GreenLake ซึ่งเป็นบริการคลาวด์ที่มีความสามารถในการจัดการและความสามารถในการตรวจสอบ วิเคราะห์และแก้ไขปัญหาได้ เพื่อดำเนินงานแบบอัตโนมัติ จัดระเบียบ และจัดการอุปกรณ์ใช้งานปลายทาง (Endpoint) เวิร์กโหลด และข้อมูลในสภาพแวดล้อมแบบไฮบริดผ่าน Control Plane เดี่ยวบนแพลตฟอร์ม ซึ่งรวมถึงตัวชี้วัดความยั่งยืนสำหรับเวิร์กโหลดและอุปกรณ์ใช้งานปลายทาง

Observability ของโครงสร้างพื้นฐาน AI และผู้ช่วย Copilot สำหรับคลาวด์ HPE GreenLake และ OpsRamp การดำเนินงานด้านไอทีของ OpsRamp ได้รับการผสานเข้ากับคลาวด์ HPE GreenLake เพื่อส่งมอบความสามารถในการตรวจสอบ วิเคราะห์ และแก้ไขปัญหา (Observability) และ AIOps ให้กับผลิตภัณฑ์และบริการของ HPE ทั้งหมด ขณะนี้ OpsRamp มอบความสามารถในการตรวจสอบสำหรับชุดคอมพิวเตอร์เร่งความเร็ว NVIDIA แบบครบวงจร ซึ่งรวมถึงซอฟต์แวร์ NVIDIA NIM และ AI, GPU NVIDIA Tensor Core และคลัสเตอร์ AI รวมถึงสวิตช์ NVIDIA Quantum InfiniBand และ NVIDIA Spectrum Ethernet ผู้ดูแลระบบไอทีสามารถรับข้อมูลเชิงลึกเพื่อระบุความผิดปกติและตรวจสอบโครงสร้างพื้นฐาน AI และปริมาณงานในสภาพแวดล้อมแบบไฮบริดและมัลติคลาวด์

สำหรับผู้ช่วยปฏิบัติการ OpsRamp รุ่นใหม่ได้ใช้แพลตฟอร์มคอมพิวเตอร์เร่งความเร็วของ NVIDIA เพื่อวิเคราะห์ชุดข้อมูลขนาดใหญ่เพื่อหาข้อมูลเชิงลึกกับผู้ช่วยสนทนา ช่วยเพิ่มประสิทธิภาพในการบริหารจัดการการปฏิบัติการ OpsRamp จะผสานรวมกับ CrowdStrike API ด้วยเพื่อให้ลูกค้าสามารถดูมุมมองแผนที่บริการแบบครบถ้วน สำหรับการรักษาความปลอดภัยปลายทาง (Endpoint Security) ครอบคลุมโครงสร้างพื้นฐานและแอปพลิเคชันทั้งหมด

เร่งระยะคุ้มทุนให้รวดเร็วยิ่งขึ้นด้วย AI – ขยายความร่วมมือกับผู้วางระบบระดับโลก

เพื่อเร่งระยะคุ้มทุนสำหรับองค์กรในการพัฒนาโซลูชัน AI เฉพาะอุตสาหกรรม และเคสการใช้งานที่มีประโยชน์ต่อธุรกิจอย่างชัดเจน บริษัท Deloitte, HCLTech, Infosys, TCS และ WIPRO ได้ประกาศสนับสนุน NVIDIA AI Computing จากชุดผลิตภัณฑ์ของ HPE และ HPE Private Cloud AI ซึ่งเป็นส่วนหนึ่งของโซลูชันและบริการ AI เชิงกลยุทธ์ของแบรนด์

HPE เพิ่มการสนับสนุนสำหรับ GPU, CPU และ Superchips ล่าสุดของ NVIDIA

● HPE Cray XD670 รองรับ NVIDIA H200 NVL Tensor Core GPU แปดตัว และเหมาะสำหรับผู้พัฒนา LLM

● เซิร์ฟเวอร์ HPE ProLiant DL384 Gen12 มาพร้อม NVIDIA GH200 NVL2 และเหมาะสำหรับผู้ใช้ LLM ที่ใช้โมเดลขนาดใหญ่หรือ RAG

● เซิร์ฟเวอร์ HPE ProLiant DL380a Gen12 รองรับ NVIDIA H200 NVL Tensor Core GPU สูงสุดแปดตัว เหมาะอย่างยิ่งสำหรับผู้ใช้ LLM ที่ต้องการความยืดหยุ่นในการปรับขนาดเวิร์กโหลด GenAI

● HPE จะพัฒนาผลิตภัณฑ์เพื่อรองรับ NVIDIA GB200 NVL72 / NVL2 พร้อมทั้งสถาปัตยกรรมNVIDIA Blackwell, NVIDIA Rubin และ NVIDIA Vera ใหม่

พื้นที่จัดเก็บไฟล์ขนาดใหญ่ได้รับการรับรองให้ใช้กับระบบ NVIDIA DGX BasePOD และ OVX HPE GreenLake for File Storage ผ่านการรับรองเพื่อใช้งานกับ NVIDIA DGX BasePOD และการตรวจสอบพื้นที่จัดเก็บข้อมูล NVIDIA OVX™ ช่วยให้ลูกค้าได้รับโซลูชันการจัดเก็บไฟล์ระดับองค์กรที่ได้รับการพิสูจน์แล้วว่าสามารถเร่งความเร็วเวิร์คโหลด AI, GenAI และ GPU ปริมาณมากได้ โดย HPE เตรียมนำโปรแกรมรับรองการจัดเก็บข้อมูลสถาปัตยกรรมอ้างอิงของ NVIDIA ออกสู่ตลาดในเร็ว ๆ นี้

ผลิตภัณฑ์และบริการที่จะมีวางจำหน่ายทั้งหมดในช่วงไตรมาส 3-4 ปี 2024

● HPE Private Cloud AI

● เซิร์ฟเวอร์ HPE ProLiant DL380a Gen12 พร้อมกับ NVIDIA H200 NVL Tensor Core GPUs

● เซิร์ฟเวอร์ HPE ProLiant DL384 Gen12 พร้อมกับ Dual NVIDIA GH200 NVL2

● เซิร์ฟเวอร์ HPE Cray XD670 พร้อมกับ NVIDIA H200 Tensor Core GPUs NVL2

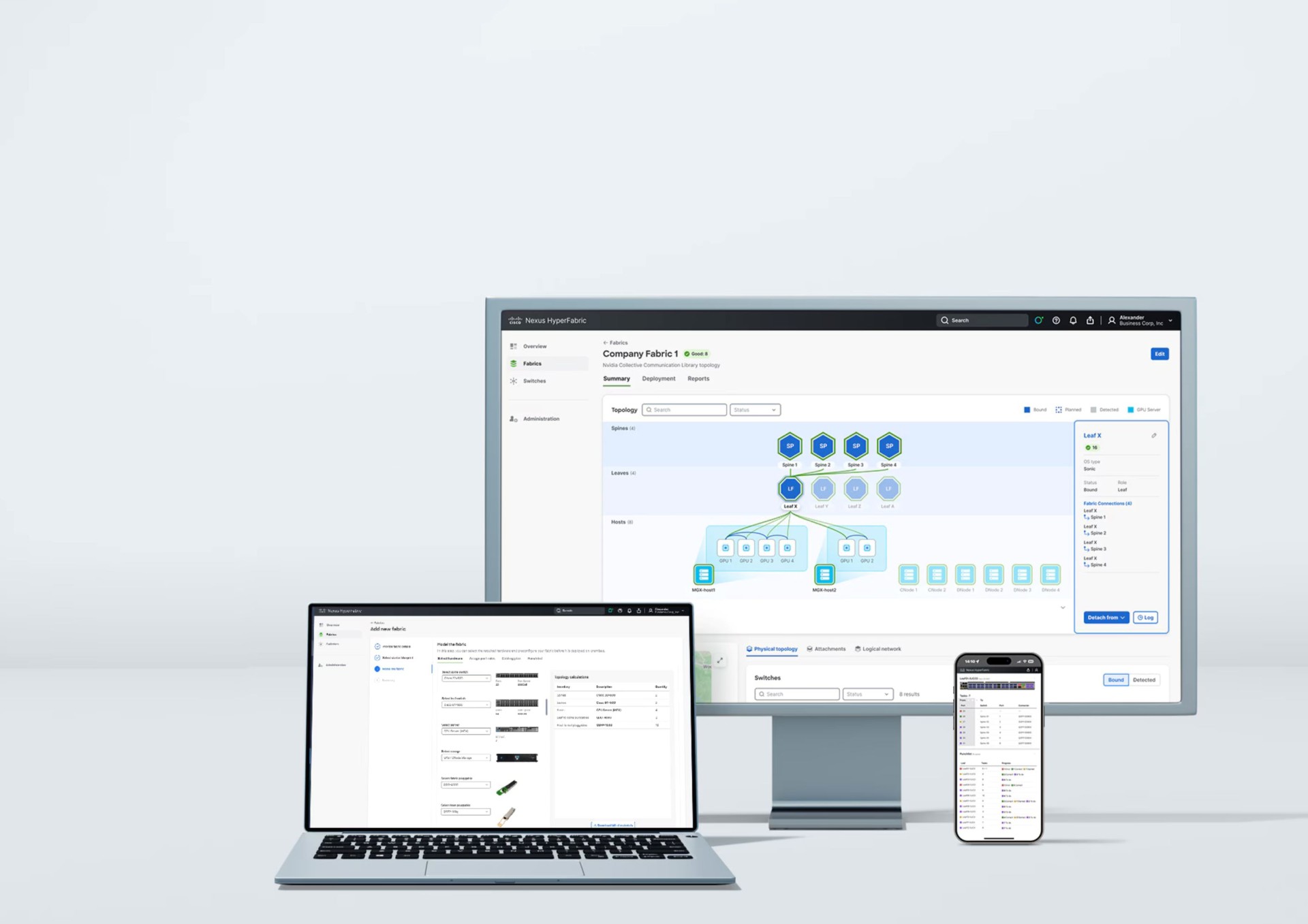

ซิสโก้ (NASDAQ: CSCO) บริษัทชั้นนำด้านเทคโนโลยีระบบรักษาความปลอดภัยและเครือข่าย ได้ประกาศเปิดตัวโซลูชั่นคลัสเตอร์ AI ที่ก้าวล้ำ พร้อมด้วยเทคโนโลยีจาก NVIDIA สำหรับดาต้าเซ็นเตอร์ยุคใหม่ที่จะพลิกโฉมการสร้าง การจัดการ และการปรับแต่งโครงสร้างพื้นฐานและซอฟต์แวร์

ภายใต้วิสัยทัศน์ Cisco Networking Cloud ซึ่งมุ่งที่จะลดความซับซ้อนของเครือข่าย ซิสโก้ได้นำเสนอโซลูชั่นโครงสร้างพื้นฐานแบบครบวงจรที่พร้อมใช้งานในระดับองค์กร เพื่อรองรับเวิร์กโหลด Generative AI โดยโซลูชั่นคลัสเตอร์ Cisco Nexus HyperFabric AI ผสานรวมเครือข่ายแบบ AI-native ของซิสโก้ เข้ากับระบบประมวลผลที่มีการเร่งความเร็วและซอฟต์แวร์ AI ของ NVIDIA และที่เก็บข้อมูล VAST ที่แข็งแกร่ง โซลูชั่นดังกล่าวได้รับการออกแบบเป็นพิเศษเพื่อช่วยให้ลูกค้าสามารถโฟกัสไปที่การสร้างสรรค์นวัตกรรมที่ขับเคลื่อนด้วย AI รวมถึงโอกาสใหม่ๆ ในการสร้างรายได้ โดยไม่ต้องวุ่นวายกับการจัดการระบบไอที

รายงานแนวโน้มด้านระบบเครือข่ายทั่วโลก (Global Networking Trends Report) ฉบับล่าสุดของซิสโก้ ระบุว่า ในช่วงสองปีข้างหน้า 60% ของผู้บริหารและบุคลากรด้านไอทีคาดว่าจะมีการปรับใช้ระบบเครือข่ายอัตโนมัติเชิงคาดการณ์ที่รองรับ AI ในทุกโดเมน เพื่อให้สามารถจัดการ NetOps ได้ดียิ่งขึ้น1 นอกจากนี้ 75% มีแผนที่จะปรับใช้เครื่องมือที่รองรับการตรวจสอบแบบครบวงจรผ่านคอนโซลหนึ่งเดียว ครอบคลุมโดเมนเครือข่ายที่แตกต่างกัน เช่น เครือข่ายแคมปัสและสาขา, WAN, ดาต้าเซ็นเตอร์, อินเทอร์เน็ต, ระบบ คลาวด์สาธารณะ และเครือข่ายอุตสาหกรรม

โจนาธาน เดวิดสัน รองประธานบริหารและผู้จัดการทั่วไปของ Cisco Networking กล่าวว่า “ถึงแม้ว่าอนาคตของ AI จะมีความชัดเจน แต่หนทางข้างหน้าสำหรับหลายๆ องค์กรที่เพิ่งเริ่มต้นการปรับใช้เทคโนโลยีกลับไม่เป็นเช่นนั้น กล่าวคือ ลูกค้าส่วนใหญ่มักจะต้องเผชิญกับปัญหาท้าทายทางด้านการเงินและการดำเนินงานสำหรับการเริ่มต้นใช้งาน AI Stack ซิสโก้มุ่งมั่นที่จะปรับปรุงการติดตั้งใช้งานและการจัดการโครงสร้างพื้นฐาน AI ให้สะดวกง่ายดายมากขึ้น โดยเราได้ร่วมมือกับ NVIDIA เพื่อนำเสนอโซลูชั่น AI Stack ที่ปรับใช้ได้อย่างง่ายดายและควบคุมผ่านระบบคลาวด์ โซลูชั่นที่ว่านี้สร้างขึ้นภายใต้วิสัยทัศน์แพลตฟอร์ม Cisco Networking Cloud ของเรา ซึ่งมุ่งเน้นการทำงานแบบอัตโนมัติและเรียบง่าย”

เควิน ไดเออร์ลิง รองประธานอาวุโสฝ่ายระบบเครือข่ายของ NVIDIA กล่าวว่า “Generative AI จำเป็นต้องใช้โครงสร้างพื้นฐานและซอฟต์แวร์ที่ออกแบบและสร้างขึ้นเพื่อการนี้โดยเฉพาะ เพื่อให้องค์กรต่างๆ สามารถเปลี่ยนข้อมูลที่มีอยู่ให้กลายเป็นเชื้อเพลิงสำหรับการพลิกโฉมธุรกิจได้อย่างปลอดภัยและมีประสิทธิภาพ NVIDIA และซิสโก้ร่วมมือกันเพื่อส่งมอบแพลตฟอร์ม AI และระบบควบคุมที่พร้อมใช้งานสำหรับองค์กร เพื่อเพิ่มความสะดวกในการติดตั้งใช้งานระบบประมวลผลแบบเร่งความเร็ว ระบบเครือข่าย และซอฟต์แวร์ที่จำเป็นสำหรับเวิร์กโหลด Generative AI”

ซิสโก้ได้ตอกย้ำถึงความมุ่งมั่นในการช่วยให้ลูกค้าสามารถปรับใช้โครงสร้างพื้นฐาน AI ได้อย่างรวดเร็ว นอกจากนี้ ซิสโก้ยังส่งมอบเครื่องมือที่เหมาะสมให้กับลูกค้าเพื่อสร้างเครือข่าย AI-native ที่ใช้งานง่าย สามารถคาดการณ์ความล้มเหลวในการทำงาน ตลอดจนวินิจฉัยและแก้ไขปัญหาได้อย่างฉับไว

วิธีการทำงานของ Cisco Nexus HyperFabric AI Cluster

โซลูชั่นนี้รองรับการออกแบบ ปรับใช้ ตรวจสอบ และรับรองพ็อด AI และเวิร์กโหลดของดาต้าเซ็นเตอร์อย่างครบวงจร โดยจะแนะนำผู้ใช้ตั้งแต่ขั้นตอนการออกแบบ ไปจนถึงการติดตั้งใช้งานที่ผ่านการตรวจสอบยืนยัน ไปจนถึงการตรวจสอบดูแลและรับรองโครงสร้างพื้นฐาน AI ที่พร้อมใช้งานระดับองค์กร ด้วยความสามารถในการจัดการระบบคลาวด์ ลูกค้าจะสามารถติดตั้งและจัดการแฟบริคขนาดใหญ่ที่ครอบคลุมทั่วทั้งดาต้าเซ็นเตอร์ ระบบโคโลเคชั่น (Colocation) และไซต์ Edge ได้อย่างง่ายดาย

โซลูชั่นคลัสเตอร์ Cisco Nexus HyperFabric AI นำเสนอการทำงานแบบอัตโนมัติที่ควบคุมจัดการผ่านระบบคลาวด์ ครอบคลุมระบบประมวลผลและเครือข่ายแบบครบวงจรที่ผสานรวมความเชี่ยวชาญด้านสวิตช์อีเธอร์เน็ตของซิสโก้บน Cisco Silicon One โดยบูรณาการเข้ากับระบบประมวลผลแบบเร่งความเร็วของ NVIDIA และซอฟต์แวร์ NVIDIA AI Enterprise รวมไปถึงแพลตฟอร์มการจัดเก็บข้อมูลของ VAST โซลูชั่นดังกล่าวประกอบด้วย:

· ความสามารถในการจัดการระบบคลาวด์ของซิสโก้ ซึ่งจะช่วยลดความยุ่งยากซับซ้อนของการดำเนินงานด้านไอทีในทุกขั้นตอนของเวิร์กโฟลว์

· สวิตช์ Cisco Nexus 6000 series สำหรับ Spine และ Leaf ซึ่งให้ประสิทธิภาพของแฟบริคอีเธอร์เน็ต 400G และ 800G

· โมดูล QSFP-DD ในตระกูล Cisco Optics ซึ่งช่วยเพิ่มทางเลือกให้แก่ลูกค้าและให้ความหนาแน่นสูงมาก

· ซอฟต์แวร์ NVIDIA AI Enterprise ซึ่งช่วยเพิ่มความคล่องตัวในการพัฒนาและปรับใช้เวิร์กโหลด Generative AI ในระดับเทียบเท่าการใช้งานจริง

· ไมโครเซอร์วิสการอนุมาน NVIDIA NIM ที่เพิ่มความรวดเร็วในการปรับใช้โมเดลพื้นฐาน พร้อมทั้งรับประกันความปลอดภัยของข้อมูล และสามารถใช้งานร่วมกับ NVIDIA AI Enterprise · NVIDIA Tensor Core GPU ที่เริ่มต้นด้วย NVIDIA H200 NVL ได้รับการออกแบบเป็นพิเศษเพื่อเพิ่มพลังให้กับเวิร์กโหลด Generative AI ด้วยสมรรถนะที่เหนือชั้นและความสามารถของหน่วยความจำที่เหนือกว่า

· หน่วยประมวลผลข้อมูล NVIDIA BlueField-3 DPU และ BlueField-3 SuperNIC สำหรับการเร่งความเร็วของเวิร์กโหลดด้านเครือข่ายประมวลผล AI การเข้าถึงข้อมูล และการรักษาความปลอดภัย

· ดีไซน์ต้นแบบระดับองค์กรสำหรับ AI ที่สร้างขึ้นบน NVIDIA MGX ซึ่งเป็นสถาปัตยกรรมเซิร์ฟเวอร์แบบแยกส่วนที่มีความยืดหยุ่นสูง

· VAST Data Platform ซึ่งให้พื้นที่จัดเก็บข้อมูลแบบครบวงจร ฐานข้อมูล และเอนจิ้นฟังก์ชั่นที่ขับเคลื่อนด้วยข้อมูลซึ่งสร้างขึ้นเป็นพิเศษสำหรับ AI

NVIDIA ส่งการ์ดจอรุ่น NVIDIA GeForce RTX 30 Series GPUs ตอบโจทย์ด้านการศึกษาควบคู่ไปกับการเล่นเกม รวมถึงการสร้างคอนเทนต์ในรูปแบบต่างๆก็สามารถทำได้อย่างดีเยี่ยม เหมาะอย่างยิ่งสำหรับนักเรียนนักศึกษาที่ต้องการโน้ตบุ๊กอันทรงพลังเพื่อเร่งความเร็วของแอปพลิเคชั่น อาทิ การศึกษาด้านวิศวกรรม วิทยาศาสตร์ข้อมูล เศรษฐศาสตร์ การศึกษาเชิงสร้างสรรค์ ศิลปะดิจิทัล และอื่นๆ อย่างมากมาย นอกจากนี้ยังเปิดโอกาสให้นักเรียนนักศึกษาได้เติมเต็มความสนุกกับการเล่นเกม โดยโน้ตบุ๊กจะสามารถรองรับการเล่นเกมด้วยในระดับ AAA ด้วยกราฟิกที่รองรับ Ray-Traced ที่ให้ภาพสมจริง พร้อมประสิทธิภาพที่เร่งความเร็วด้วย AI ในโน้ตบุ๊กที่ใช้ GeForce RTX 30 Series จะสามารถนำเสนอสิ่งเหล่านี้ได้เป็นอย่างดี ด้วยการดีไซน์แบบบางและน้ำหนักเบา ทำให้นักเรียนนักศึกษาสามารถนำติดตัวไปได้ทุกที่ด้วยอายุการใช้งานแบตเตอรี่ที่ยาวนาน